Fortschritte bei der Entwicklung von Grafikkarten haben der Visualisierung im Engineering zum Durchbruch verholfen. Lesen Sie im Einführungsbeitrag zu unserem Lexikon über Technologien zur intuitiven Interpretation virtueller Szenen, wie wichtige Meilensteine 3D-Modelle immer näher an die Wirklichkeit rücken ließen.

Ihren Ursprung hat die Computergrafik in den 1950er-Jahren, als Rechner erstmals mit grafischen Ausgabegeräten („Terminals“) ausgestattet wurden. Es kamen kommerzielle Vektorbildschirme auf den Markt, die Punkte und Linien anzeigen konnten. Ein wichtiger Wegbereiter war Ivan Sutherland. Sein Tool Sketchpad, das er im Rahmen seiner Doktorarbeit 1963 am MIT entwickelte, gilt als eine der ersten interaktiven Grafikanwendungen. Gegen Ende der 1960er Jahre sorgten erstmals bezahlbare Computerterminals mit Speicherröhren-Grafikbildschirmen für Furore. Zu dieser Zeit wurden außerdem wichtige Verfahren wie Raytracing und Bildzeilen-Algorithmen entwickelt. Letztere bedienen sich zur Verdeckungsberechnung der aus Polygonen aufgebauten 3D-Szenen der Reduktion der Problems von drei auf zwei Dimensionen. In den 1980er Jahren setzten sich Eingabegeräte wie (2D-)Maus und Grafiktablett durch. Auch Farbdrucker kamen auf den Markt. Gleichzeitig wurden Vektorbildschirme allmählich von Rasterbildschirmen, die farbig gefüllte Flächen anzeigen konnten, verdrängt. PCs, die nun massenhaft produziert wurden, verfügten noch über eine lausige Grafikleistung, was sich jedoch bald ändern sollte. Immerhin brachte SolidWorks 1995 sein erstes rein Windows-basiertes 3D-CAD-System auf den Markt. Dennoch: Bis weit in die 1990er Jahre hinein war Visualisierung ausschließlich ein Thema von gut bezahlten Experten und für Supercomputing mit einzelnen Großrechnern, etwa von Cray, und später von Rechnerverbünden, zum Beispiel bestehend aus diversen „Graphic Pipes“ von SGI. Der Konstrukteur selbst war nicht der Lage, ansprechende Visualisierungen zu kreieren. Die 3D-Daten, die überwiegend auf Unix-Rechnern erzeugt wurden, wurden von internen oder externen Dienstleistern mit speziellen Tools zeitaufwendig aufbereitet („tesseliert“) und dann in gesonderten Räumen präsentiert. Dabei konnte schon mal eine Woche und mehr vergehen, bis man die – dann bereits veralteten – Daten in der Gruppe diskutieren konnte. Von durchgehenden Prozessketten nach heutigem Verständnis, bei denen Visualisierung ein integraler Bestandteil der Entscheidungsfindung ist, konnte keine Rede sein. High-Performance Compute Cluster wurden erstmals als sogenannte Renderfarmen eingesetzt. Üblicherweise werden dazu handelsübliche IBM-kompatible- oder Apple-Computer unter den Betriebssystemen Linux, Mac OS X oder Windows verwendet. Renderfarmen bewiesen ihre Leistungsfähigkeit unter anderem bei opulenten Digital Content Creations (DCC) für Kinofilme wie „Titanic“ (1997) oder „Der Herr der Ringe“ (2001 bis 2003).

Stimuliert von den neuen Möglichkeiten durch Browser und Internet (HTTP), erreichten PCs um die Jahrtausendwende ausreichend Leistung, um erstmals Computergrafik und die Verarbeitung von Bild- und Toninhalten kombinieren zu können. Unter dem Schlagwort „Multimedia“ verschwommen allmählich die Grenzen zwischen der reinen Computergrafik und anderen Medien.

Visualisierung auf dem PC: Grafikkarten machen’s möglich

Auch bei der Entwicklung von Grafikkarten ging es mit großen Schritten voran. Den zunehmenden Innovationsdruck bekamen insbesondere Hersteller von professionellen Grafikkarten zu spüren, etwa 3Dlabs, das daran mehr oder weniger zugrunde ging. Das Unternehmen entwickelte die Highend-Grafikchips Glint und Permedia, die in vielen Grafikkarten für CAD- und DCC-Anwendungen zum Einsatz kamen, einschließlich der 3Dlabs-eigenen Wildcat- und Oxygen-Karten. Die herausragende Leistung von 3Dlabs war, dass es die performante Darstellung von 3D-Grafiken auf PCs ermöglichte. So war Permedia der erste bezahlbare OpenGL-Grafikprozessor. Auch trieb man als Mitglied des sogenannten OpenGL Architecture Review Board die Entwicklung von OpenGL 2.0 voran. So war es ungefähr ab dem Jahr 2002 erstmals möglich, dass der Anwender an seinem Windows-PC anspruchsvolle Visualisierungen auf Basis von 3D-Inhalten erzeugen konnte. 2006 fiel der Vorhang für 3Dlabs, das inzwischen seine Eigenständigkeit an Creative Labs verloren hatte, indem man diesen Geschäftsbereich aufgab. Der Grund: 3Dlabs hatte sich zu 100 Prozent der Entwicklung und Herstellung professioneller Grafikkarten verschrieben; Anbieter wie Nvidia oder AMD mit Fokus auf den Consumer-Bereich indes gaben eine deutlich höhere Schlagzahl bei der Präsentation neuer Produkte vor, weil es ihnen gelang, ihre Karten für CAD- oder DCC-Anwendungen zu adaptieren. So kamen jedes Jahr neue Karten mit beachtlichen Performance-Steigerungen auf den Markt, während es bei 3Dlabs schon mal drei Jahre dauerte, bis eine wirklich neue Karte präsentiert werden konnte. Nach heutigem Stand sind von den rund 7.500 Mitarbeitern bei Nvidia mehr als die Hälfte in Forschung und Entwicklung tätig – in den Hochzeiten von 3Dlabs waren es gerade einmal 300. Natürlich ging es auch anderen Firmen beziehungsweise Geschäftsbereichen so, die diese Manpower ebenfalls nicht vorweisen konnten.

Performante Grafiksoftware wie 3D-CAD- oder auch Virtual-Reality-Anwendungen sind auf Treibersoftware angewiesen, die die Grafiksoftware-Befehle in hardwarenahe Funktionen übersetzen. Viele Treiber basieren auf der Open Graphics Library (OpenGL). OpenGL wurde als Spezifikation für eine plattform- und programmiersprachenunabhängige Schnittstelle entworfen, die nicht bei jedem Funktionsaufruf alle benötigten Parameter erhält, sondern so lange dieselben Werte verwendet, bis die entsprechenden Zustände sich ändern. Diese ökonomische Vorgehensweise hilft, eine möglichst performante Grafikausgabe am Bildschirm zu erreichen, weil nur das neu berechnet wird, was sich geändert hat. Ein großer Sprung in Sachen Hardwarebeschleunigung stellte die Version 2.0 von OpenGL aus dem Jahr 2002 dar, die es erstmals erlaubte, mittels dieses standardisierten Befehlssatzes auf dem Grafikprozessor eigene Programme, sogenannte Shader, laufen zu lassen. Shader berechnen das Aussehen eines 3D-Objekts oder erzeugen Spezialeffekte, etwa die Texturierung und die Beleuchtung. Ein weiterer wichtiger Meilenstein war im PC-Bereich die Einführung des Bussystems PCIe („Peripheral Component Interconnect Express“) für die Kommunikation zwischen dem Chipsatz der CPU und Periphergeräten wie der Grafikkarte. PCIe ist im Vergleich zu seinem Vorgänger, dem parallelen PCI-Bus, kein geteiltes Bussystem mehr, sondern eine separate serielle Punkt-zu-Punkt-Verbindung. Damit lassen sich auf der Grafikkarte Daten gleichzeitig lesen und schreiben, was einer Beschleunigung um Faktoren gleichkam. Erste PCIe-Karten kamen 2004 auf den Markt.Weiter ging es mit der Vernetzung von Grafikkarten untereinander. Nvidia zum Beispiel brachte 2005 skalierbare Quadro-Genlock/Framelock-Lösungen heraus, um seine Quadro-Karten vom Typ FX 4400 zu vernetzen, was einen deutlichen Performance-Schub bedeutete. Eine Art Netzwerkkarte zusätzlich zu den Grafikkarten erlaubte es, Synchronisationssignale über verschiedene Rechnerplattformen hinweg auszutauschen, so dass mehrere Grafikkarten synchron am gleichen Bild rechnen. Nicht vergessen werden darf der Hinweis auf die Weiterentwicklung von Grafikchips zu richtigen Graphic Processor Units (GPUs). Zuvor waren die Grafikchips eigentlich nichts anderes als in Silizium gegossenes Open GL gewesen. Die Bezeichnung „GPU“ wurde erstmals von Nvidia intensiv genutzt, um die 1999 erschienene Nvidia-GeForce-256-Serie zu vermarkten. GPUs sind wegen ihrer Spezialisierung auf Grafikberechnungen und Konzentration auf massiv parallelisierbare Aufgaben den CPUs in ihrer Rechenleistung überlegen. GPUs, wie die Quadro- und Tesla-Grafikprozessoren von Nvidia, werden inzwischen auch genutzt, um in virtuellen Szenen Physikberechnungen (mittels PhysX) durchzuführen, was den Realismus deutlich steigert.

Immersion und 3D-Monitore

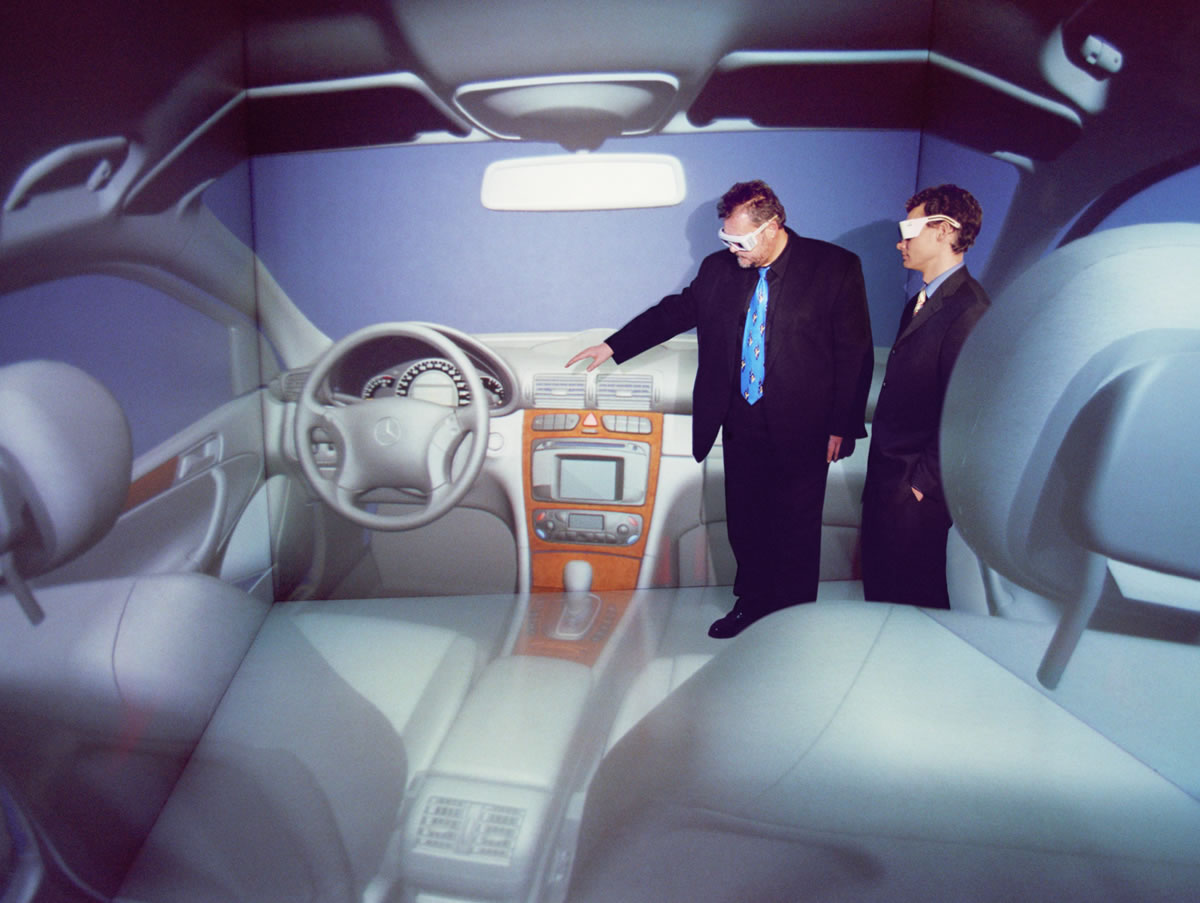

Beispiele für sehr anspruchsvolle Visualisierungen finden sich im Bereich von Virtual Reality (VR) beziehungsweise immersiver Stereoskopie. Um einen räumlichen Eindruck gerade von großen Bauteilen oder Baugruppen zu erhalten, werden zwei Bilder aus unterschiedlichen Blickwinkeln mit einer Frequenz von mindestens 25 Bildern pro Sekunde getrennt für das linke und das rechte Auge erzeugt und auf einer Powerwall dargestellt. Eine Fahrsimulation beispielsweise erfordert allerdings mindestens 60 Bilder pro Sekunde, um Übelkeit zu vermeiden.Um ein Bild dem jeweils richtigen Auge zuzuführen, existieren verschiedene Technologien. Man unterscheidet aktive (etwa Shutterbrillen) und passive (zum Beispiel Brillen mit Polarisationsfilter). Für die Interaktion mit VR-Szenarien kommen 3D-Eingabegeräte, Datenhandschuhe oder sogenannte Flysticks zum Einsatz. Der Flystick dient zur Navigation mit einem optischen Trackingsystem, wobei Infrarot-Kameras permanent die Position mithilfe von Markern am Flystick oder direkt der bedienenden Person erfassen und dem VR-System melden. Allerdings ist dies eine ziemlich teure Angelegenheit, weil dafür mindestens 20.000 Euro auf den Tisch gelegt werden müssen. Bei einem gewöhnlichen 2D-Monitor wird nur ein Bild innerhalb einer Sechzigstelsekunde gezeigt. Bei Aktiv-Stereo-Monitoren wird die Bildwiederholrate verdoppelt, somit stehen jedem Auge pro Sekunde 60 Bilder zur Verfügung, die nacheinander abwechselnd gezeigt werden. Um die Bilder voneinander zu trennen, wird die Aktiv-Shutter-Stereo-Brille mit Monitor beziehungsweise Grafikkarte synchronisiert. Sie kosten zwischen 250 und 300 Euro, was sie für den Einsatz in einem 3D-Kino mit einer großen Anzahl von Zuschauern zu teuer macht. Der stolze Preis rührt daher, dass sie sehr schnell, nämlich jede Hundertzwanzigstelsekunde, verdunkeln müssen.

Der zweite Brillentyp nennt sich passiv stereo. Der Monitor sendet Licht in bevorzugter Schwingungsrichtung, und die Brille lässt jeweils nur das Licht mit einer bestimmten Polarisationsrichtung durch. Da der Monitor in diesem Fall stets beide Bilder anzeigt, sieht man ohne Brille zwei leicht zueinander versetzte Bilder, was die Abbildung sehr unscharf erscheinen lässt. Bei preiswerteren Geräten ist die Bildauflösung halbiert, was bedeutet, dass bei einer Monitorauflösung von 1.920 x 1.080 Bildpunkten jeweils 540 Zeilen für ein Auge verwendet werden – die ungeradzahligen Zeilen 1, 3, 5,… für das rechte, die geradzahligen für das linke Auge. Der Vorteil: Es müssen nur insgesamt 60 Bilder pro Sekunde erzeugt werden. Der Nachteil: Die Hälfte der Auflösung geht verloren. „Im Kinobereich ist das nicht wirklich kritisch, bei CAD-Anwendungen schon, weil hier mit Drahtgittern und anderen sehr dünnen Linien gearbeitet wird. Wenn dann jeder zweite Punkt fehlt, nimmt man eine Linie möglicherweise als gestrichelt wahr, was irritierend ist“, erklärt uns Stefan Hummel, Field Marketing Manager Professional Solutions bei der PNY Technologies Quadro GmbH mit Sitz in Würselen. Andererseits kosten Polarisationsbrillen lediglich drei bis fünf Euro, was sie für den Einsatz bei einer größeren Menge von Betrachtern attraktiv macht. Sie werden in Kombination mit zwei Projektoren eingesetzt. Diese müssen freilich sauber justiert werden, nicht nur in Hinsicht auf die Bildposition, sondern auch in Hinsicht auf die identische Helligkeit. Apropos Helligkeit: Das ist derzeit der größte Knackpunkt bei der Stereoprojektion, wie Hummel meint. Freilich nicht bei den Monitoren, denn die erreichen inzwischen bis zu 600 Candela (cd), was sehr viel ist, wenn man bedenkt, dass für eine normale Arbeitsplatzumgebung 150 cd ausreichen. „Selbst wenn eine Polarisationsbrille aufgesetzt wird, die zwischen 50 und 75 Prozent des Lichts absorbieren, ist immer noch genügend Helligkeit vorhanden“, meint Hummel. Nur beim Einsatz von Projektoren sieht die Sache anders aus. Wird aufgrund der Lichtverhältnisse ein Projektor mit 6.000 ANSI Lumen verwendet anstatt mit 1.500 (rund 250 cd), muss man tief in die Tasche greifen – anstatt etwa 700 Euro sind dann nämlich 20.000 Euro fällig! Und für die stereoskopische Darstellung werden zwei Projektoren benötigt!